박준석

데이터 사이언티스트입니다.

심리학을 전공했지만 졸업 후에는 미국에서 데이터과학자로 일하고 있습니다. 데이터를 가지고 가치 있는 활동을 하는 데 관심이 많습니다. [가짜뉴스의 심리학], [3일 만에 끝내는 코딩 통계], [데이터과학자의 일] 등을 썼습니다.

내적에 대한 더욱 심오한 천기누설

내적 (dot product) 과 그 기하학적 의미, 통계/기계학습과의 관련성

내적 (dot product) 과 그 기하학적 의미, 통계/기계학습과의 관련성

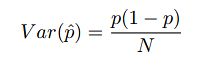

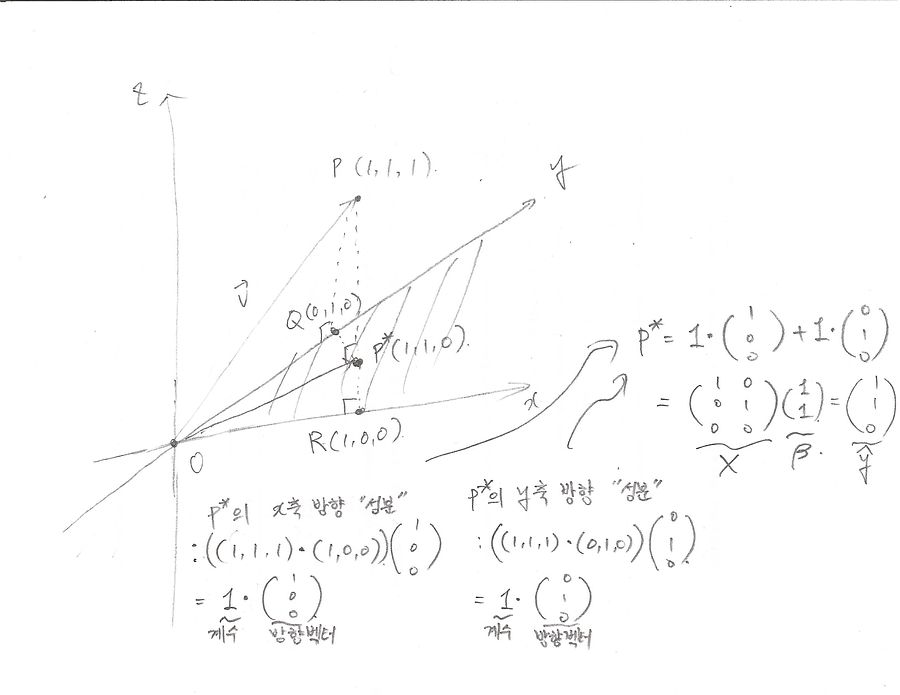

오늘은 좀 가벼운(?) 주제에 대해 이야기해볼까 한다. 바로 벡터 간의 곱에 대한 이야기다. 아는 사람들은 다 아는 이야긴데 벡터 간의 곱셈은 통계학과 기계학습에서 엄청나게 자주 등장하고 중요한 개념이다. 그런데 중요한 건 그게 어떤 기하학적 의미를 갖는다는 것이고, 이를 잘 이해하면 통계/기계학습 관련 개념 이해에 무진장 도움이 된다는 것이다. 그래서 오늘은 짧게 이 얘기를 해 보려고 한다.

(주의: 두 벡터를 곱하는 방법은 한 가지가 아니다. 그래서 이 글에서 말하는 곱셈이 두 벡터를 곱하는 유일한 방법이라고 오해하면 안 된다.)

먼저 벡터 간의 곱셈이 뭔지부터 얘기를 해야 할 것 같다. 그러기 위해서는 벡터가 뭔지 얘기를 해야 한다. 벡터는 쉽게 말하면 그냥 숫자를 죽 한 줄로 나열한 것이다. 이를테면 다음과 같은 것은 벡터다 (대개 벡터를 쓸 때는 괄호 안에 숫자를 죽 나열한다).

(1, 2, 3, ..., 10)

자, 그럼 이제 벡터 얘기를 다 했다. 놀랍겠지만...

데이터 사이언스 맥시멀리스트의 위시리스트 (2) - 통계학

데이터 사이언스 맥시멀리스트의 위시리스트 (1) - 엔지니어링 기초

구닥다리(?) 데이터 사이언스의 현주소

운칠기삼, 하지만 '운'도 사실 통제할 수 있다?

미스터리한 숫자, 여론조사 표본오차 "3.1%" 에 숨겨진 비밀 (부제: 님하 그 표본오차를 그렇게 쓰지 마오)

미스터리한 숫자, 여론조사 표본오차 "3.1%" 에 숨겨진 비밀 (부제: 님하 그 표본오차를 그렇게 쓰지 마오)

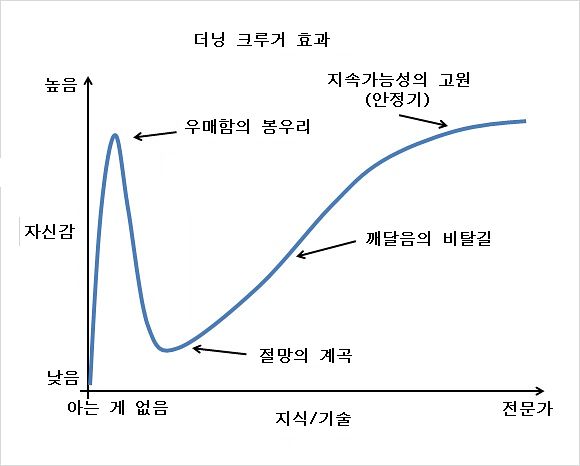

뉴스와 신문지상에 등장하는 여론조사에 꼭 등장하는 항목이 있습니다. “본 설문조사에는 …명을 대상으로 …방식으로 진행되었으며 표본오차는 3.1% 입니다.” 여기서 3.1%라는 숫자에 크게 관심을 갖고 보신 분은 별로 없겠지만, 뭔가 이상하지 않습니까? 설문조사마다 표본오차가 거의 같으니 말입니다. 이상하게 3.1%에서 크게 빗나가는 법이 없죠. 여기서 통계학에 조금 더 조예가 있으신 분들이라면 표본오차가 표본 크기에 좌우된다는 것을 알고 계실 테니, 설문조사마다 1,000명 안팎을 대상으로 조사를 한다면 표본오차도 대략 비슷할 것이라는 점은 눈치채셨을 것입니다. 그런데 왜 하필 그 값이 3.1% 인지까지는 아시는 분이 많지 않으리라 생각합니다. 그래서 이 글에서는 그에 대한 설명을 좀 하고요.

사실 이 기사 (JTBC 2023년 2/8 보도, 엇갈린 국힘 당대표 후보 여론조사…김 45.3%, 안 30.4% vs 안 35.5%, 김 31.2%) 때문에 이 글을 쓰게 되었습니...