라이뷰

Ask Me Anything

한국 최고의 AI 전문가에게 물어보세요

2023/12/19

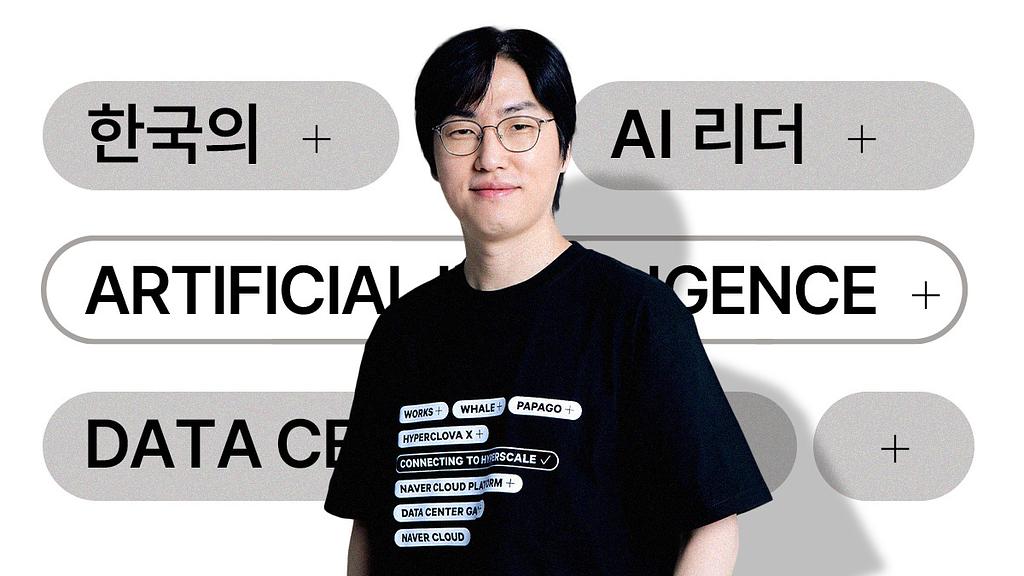

한국 최고의 AI 전문가

하정우 네이버클라우드 AI 이노베이션 센터장

하정우 센터장은 국내 AI계의 대부, 서울대 장병탁 교수 밑에서 AI 공부를 시작했습니다. 학생 시절에는 유학을 염두에 두기도 했지만 결국에는 국내 대학을 졸업 후 2015년 네이버랩스에 입사했습니다. 입사 후 이세돌-알파고 대국이 있었고 AI가 화두가 되면서 많은 관심과 기회를 얻었다고 말합니다.

2019년부터는 AI가 핵심기술로 부상했고, 회사를 넘어 국가 차원에서 AI 경쟁력이 중요해지기 시작했죠. 하정우 센터장은 회사에서의 AI 전략 역할이 늘어나고 정부의 AI 방향에도 많이 참여하게 되면서 ‘소명의식'도 갖게 되었다고 하는데요. 전세계에서 3번째로 초거대AI 개발을 성공시키며 이제는 명실상부한 한국의 AI 리더로 자리매김했습니다.

하정우 센터장에게 한국에서 초거대 AI를 만들어 낸 저력은 무엇이고, 어떤 어려움을 겪고 있는지, 또 앞으로 가야 할 길은 어떠한지를 물었습니다.

여러분은 AI와 함께 살 준비를 잘 하고 계신가요?

성큼성큼 다가오고 있는 AI 시대를 바라보며,

또 적응하려고 노력하며 생긴 어떤 궁금증이나 고민도 좋습니다.

또 적응하려고 노력하며 생긴 어떤 궁금증이나 고민도 좋습니다.

하정우 센터장에게 물어보세요.

💬 AI를 공부하고 싶은 사람

💬 AI로 비즈니스를 하고 싶은 사람

💬 AI를 더 잘 사용하고 싶은 사람 등

😉 AI에 관심있는 사람이라면 어떤 질문이라도 좋아요.

21일(목)부터 23일(토)까지 질문을 남겨주시면

하정우 센터장이 얼룩소에 등장해 좋은 질문을 선정해 답글을 달아줍니다.

21일(목)부터 23일(토)까지 질문을 남겨주시면

하정우 센터장이 얼룩소에 등장해 좋은 질문을 선정해 답글을 달아줍니다.

좋은 질문을 한 질문자를 선정해 5000 포인트를 드립니다.

21일부터 23일까지 하루에 1명씩 선정하고

발표는 22일, 26일 오전 9시에 발표합니다.

네이버클라우드 AI Innovation 센터장으로서 팀네이버의 중장기 AI 선행연구, AI safety 그리고 글로벌 AI 생태계 전략을 총괄하고 있습니다.

디플정위원회 초거대 공공 AI TF 팀장, 공학한림원 컴퓨팅분과 회원, AI미래포럼 공동의장으로 활동 중입니다.

.jpg)

12/26 댓글 이벤트 당첨자는 @rtrtcom93 @공무원코딩 입니다. 포인트는 1/3 지급 예정입니다. 좋은 질문 주셔서 감사합니다.

@하정우 님~ 앞으로의 발전을 뒤에서 열심히 응원하겠습니다.자세한 답변 감사합니다~

즐거운 하루 보내세요^^

@똑순이

질문 주셔서 감사합니다. 제가 제 책인 AI전쟁에서도 언급했다시피 의료가 AI가 기여할 수 있는 가장 중요란 분야중 하나인데요. 저희 네이버에서는 사내병원과 헬스케어연구소를 별도로 운영중이고 저희 네이버클라우드 AI Innovation 센터 내에 Digital healthcare lab 에서 의료 AI 부분을 열심히 연구중입니다. 최근에는 하이퍼클로바X 의 의료분야 능력향상 통한 활용, 사내병원 진료진 분들의 생산성 도구, 건강관리를 위한 응용, 인과관계 설명가능성 강화 등의 연구를 외부 대형병원들과 함께 수행하고 있습니다.

의료분야 인공지능은 이미 국나에사 루닛이나 뷰노 같은 회사들이 매우 잘하고 있고 루닛은 식약처 허가도 받았다고 하고요 특히 영상판독에서 최근 gpt-4v의 가능성등 더 많이 활용될 것으로 보입니다

@rtrtcom93

안녕하세요. 굉장히 의미있는 질문 주셨어요.

1. 편향성과 최근 LLM이 추구하는 일반화 능력은 조금 분리할 필요가 있다고 생각합니다. 세상 삼라만상 모든 것에 대해 정확히 이해가고 추론하는 모델을 만들 수 있으면 좋겠으나 제한된 model capacity (요즘은 거의 flops 입니다) 내에서 ai를 설계하는 조직 관점에서 더 중요한 문제들을 두루두루 잘하는 것이 중요하고 그 과정에서 상대적으로 덜 중요한 (기업입장에서는 마켓사이즈가 작은) 쪽애서 편향성이 발생할 수 있습니다. 즉.. 모든 문화권 80점짜리 보다 북미영어문화권 95점 기타지역 70점으로 만드는 것이 이득이기 때문이지요. 그런 의미에서 소버린AI 중요성에 대해 강조드린 것입니다. 실제로 AI 안전 정상회의에서 최소 AI 신뢰성이나 안전에 대해선 다자주의, 다양성, 포용성을 강화해야 한다는 공감대가 있었고 그런 노력들이 진행되고 있습니다.

2. Pre-training 단에서는 데이터의 양이 질보다 중요하다는 것이 알려져 있고 대량의 데이터 확보가 어랴운 곳에서는 품질이 과도하게 낮은 데이터 필터아웃을 강하게 하지 않는 것으로 보이기도 합니다. 그러나 또 다른 최신 연구들은 학습단에서 활용된 데이터 probing 하는 연구들이 계속 잔행되고 있어서 리스크가 될 수 있고 가급적 어떤 데이터가 활용되었은지 개략적 수준에서라도 공개하는 방향으로 논의가 진행되고 있어서 만드는 곳들의 전략적 선택의 문제가 될 수 있겠습니다. 다만 오픈소스 진영에서 고의로 악용을 위해 질나쁜 데이터를 활용하는 부분 방지릉 위한 자체 노력은 필요할 수 있겠고 생성AI 공동질서에서 논의되어야 할 부분이라고 생각합니다.

12/22 댓글 이벤트 당첨자는 @songkim 입니다. 포인트는 12/27 지급 예정입니다. 감사합니다.

안녕하세요^^

오스트레일리아 영화 업그레이드를 보았습니다.

괴한의 습격으로 전신 마비가 된 남자 주인공 그레이가 인공지능 스템 을 경추에 장착을 하고 아내를 죽인자를 찾아 복수를 하는 영화였는데요.

병원에 근무하고 있는 저는 영화라서 가능 한 일 같기는 하나 다가오는 미래에 진짜 가능할것 같다는 생각이 들기도 했습니다.

혹시 사람을 살리는 의료쪽으로도 연구 개발하려는 의향이 있으신지요??

그리고 의료 쪽으로는 인공지능이 지금 얼마나 사용되고 있는지 궁금합니다.

감사합니다^^

안녕하세요, 좋은 글 남겨주셔서 감사합니다. 아직 인공지능에 대한 지식이 많이 없지만, 인공지능 모델을 학습 시킬 때, 필연적으로 거대한 데이터가 필요하다는 사실만 대략적으로 알고 있는 사람입니다.

위 글로부터 떠오른 몇가지 질문을 말씀 드리면,

1. 말씀해주신 것처럼 필연적으로 학습시킬 데이터에는 Bias가 들어갈 수 밖에 없으며 이때 Bias를 결정하는 것 또한 그 데이터를 추출하는 Field (위에서 말씀해주신 지식, 문화, 등)에 영향을 받는다고 하셨습니다. 인공지능이 목표로 하는 가치 중에 하나가 바로 일반성(Generality)이라고 알고 있는데, AI 다양성과 이 목표는 일부 모순점이 존재하는 것처럼 느껴집니다. 앞으로 하이퍼 클로바가 세계 시장에서 경쟁력을 가지려면 사실 이 모순점을 해결하는게 관건이라는 생각이 드는데요,

이를 위해서 플랫폼이 가지고 있는 기술적인 노력 뿐만 아니라 다양한 학문 분야(철학, 역사 등)와의 협업을 위한 TF 같은 것을 만드실 생각은 없는지 여쭤보고 싶습니다.

2. 결국엔 AI 경쟁력을 갖추기 위해선 다량의 데이터를 학습시켜야 하는데, 상대적으로 규제가 느슨한 해외의 경우에는 의도적인지 의도치 않은 것인진 모르겠지만, 다소 윤리/비윤리 경계선의 방법으로 모델을 학습시켜온 것으로 보입니다. 다소 과격하더라도 AI 경쟁력을 위해선 그런 회색의 경계를 이용해야 할까요?

@Fred Kim

중요한 질문 주셔서 감사합니다~ 사실 워낙 자주 받는 질문인지라 ㅎㅎㅎ

질문 주신 내용은 사전 질문으로 들어와서 위의 글에 제가 설명을 드렸는데요. 한번 확인 부탁드리겠습니다.

@공무원코딩

저희 CLOVA X를 애용해주셔서 감사합니다~ 아무래도 CLOVA X는 ChatGPT 처럼 프롬프트만으로 컨트롤 해야하다보니 다소 제약이 있는 것이 사실인데요. 더불어 대국민 서비스이다보니 안전성도 훨씬 강하게 적용되어 있습니다.

그래서 말씀 주신 부분에 적용을 위해서는 CLOVA Studio 를 통해 HyperCLOVA X를 직접 튜닝하거나 API 형태로 사용하시면 어떨까 합니다.

https://www.ncloud.com/product/aiService/clovaStudio 요기에서 신청 가능하십니다.

@songkim 아주 중요한 질문 주셔서 감사합니다! 사실 OpenAI와 구글의 여러 계약을 시작으로 생성 AI 기업과 컨텐츠 저작자간의 논의가 상당히 많이 진행되고 있는데요. 실제 저희도 국내 언론사나 관련 협회 등과 논의가 진행되고 있는 것으로 알고 있습니다. 사실 미디어 뿐 아니라 전문지식류의 데이터도 별도로 확보하기 위해 노력중이고 실제 많은 논의가 진행중인데요.

다만 기술적으로 개별 컨텐츠가 학습데이터로서 얼마나 컨텐츠 생성이나 품질에 기여하는 지 정확하게 측정이 어렵기도 하고 컨텐츠를 만드는 방법의 패러다임이 완전히 바뀌고 있는 현 상황에서 컨텐츠를 건당 가격얼마 하는 기존의 보상방법을 쓰긴 어렵지 않나 보고 있고요. 대신 기술(+경우에 따라 컨텐츠 가치에 해당하는 보상)과 컨텐츠의 맞교환을 포함한 기존과 좀 다른 형태의 논의도 필요하다고 생각합니다.

사실 이 건과 별개로 사람이 만든 데이터는 어쨋든 편향적인 한계가 있는 데 이를 해결하기 위한 생성AI가 강화학습 기반으로 만들어 낸 합성 데이터로 사람 데이터만으로 학습한 모델의 한계를 극복하기 위한 연구도 최근 들어 소개 되고 있고 (Singh et al. Beyond Human Data: Scaling Self-Training for Problem-Solving with Language Models. 2023 나 Feng et al. Alphazero-like Tree-Search can Guide Large Language Model Decoding and Training. 2023) 요즘 OpenAI 가 만들었다고 알려진 Q*도 그런 연구의 결과라는 카더라 통신도 있어서 저희도 이쪽으로 집중해서 보고 있습니다.

@하정우 님~ 앞으로의 발전을 뒤에서 열심히 응원하겠습니다.자세한 답변 감사합니다~

즐거운 하루 보내세요^^

@똑순이

질문 주셔서 감사합니다. 제가 제 책인 AI전쟁에서도 언급했다시피 의료가 AI가 기여할 수 있는 가장 중요란 분야중 하나인데요. 저희 네이버에서는 사내병원과 헬스케어연구소를 별도로 운영중이고 저희 네이버클라우드 AI Innovation 센터 내에 Digital healthcare lab 에서 의료 AI 부분을 열심히 연구중입니다. 최근에는 하이퍼클로바X 의 의료분야 능력향상 통한 활용, 사내병원 진료진 분들의 생산성 도구, 건강관리를 위한 응용, 인과관계 설명가능성 강화 등의 연구를 외부 대형병원들과 함께 수행하고 있습니다.

의료분야 인공지능은 이미 국나에사 루닛이나 뷰노 같은 회사들이 매우 잘하고 있고 루닛은 식약처 허가도 받았다고 하고요 특히 영상판독에서 최근 gpt-4v의 가능성등 더 많이 활용될 것으로 보입니다

@Fred Kim

중요한 질문 주셔서 감사합니다~ 사실 워낙 자주 받는 질문인지라 ㅎㅎㅎ

질문 주신 내용은 사전 질문으로 들어와서 위의 글에 제가 설명을 드렸는데요. 한번 확인 부탁드리겠습니다.

@songkim 아주 중요한 질문 주셔서 감사합니다! 사실 OpenAI와 구글의 여러 계약을 시작으로 생성 AI 기업과 컨텐츠 저작자간의 논의가 상당히 많이 진행되고 있는데요. 실제 저희도 국내 언론사나 관련 협회 등과 논의가 진행되고 있는 것으로 알고 있습니다. 사실 미디어 뿐 아니라 전문지식류의 데이터도 별도로 확보하기 위해 노력중이고 실제 많은 논의가 진행중인데요.

다만 기술적으로 개별 컨텐츠가 학습데이터로서 얼마나 컨텐츠 생성이나 품질에 기여하는 지 정확하게 측정이 어렵기도 하고 컨텐츠를 만드는 방법의 패러다임이 완전히 바뀌고 있는 현 상황에서 컨텐츠를 건당 가격얼마 하는 기존의 보상방법을 쓰긴 어렵지 않나 보고 있고요. 대신 기술(+경우에 따라 컨텐츠 가치에 해당하는 보상)과 컨텐츠의 맞교환을 포함한 기존과 좀 다른 형태의 논의도 필요하다고 생각합니다.

사실 이 건과 별개로 사람이 만든 데이터는 어쨋든 편향적인 한계가 있는 데 이를 해결하기 위한 생성AI가 강화학습 기반으로 만들어 낸 합성 데이터로 사람 데이터만으로 학습한 모델의 한계를 극복하기 위한 연구도 최근 들어 소개 되고 있고 (Singh et al. Beyond Human Data: Scaling Self-Training for Problem-Solving with Language Models. 2023 나 Feng et al. Alphazero-like Tree-Search can Guide Large Language Model Decoding and Training. 2023) 요즘 OpenAI 가 만들었다고 알려진 Q*도 그런 연구의 결과라는 카더라 통신도 있어서 저희도 이쪽으로 집중해서 보고 있습니다.

현재 CUE:로 검색을 할 때 "이 이슈에 관해 A언론이 보도한 뉴스를 줘"라고 하면 특정 언론사의 뉴스를 검색 결과로 내놓질 않더라고요. CP사임에도 불구하고요. 그래서 네이버가 국내 미디어 회사(특히 언론)과 AI 개발에 필요한 콘텐츠 수급을 두고 협상 중이거나 난항을 겪고 있다고 추측됩니다. 아무래도 콘텐츠 저작권 문제가 있을 테니까요.

며칠 전 오픈AI와 악셀 슈프링어가 콘텐츠 파트너십을 체결하면서, AI개발사가 모델 학습을 위한 고품질 학습 데이터를 미디어 회사로부터 수급하는 시도가 본격화된 것으로 보입니다. 국내의 경우도 비슷할 거라고 추측하는데요.

특히 국내 최대 플랫폼인 네이버가 국내 뉴스 유통에서 아주 큰 비중을 차지하는 만큼 네이버와 국내 미디어 회사 간 데이터 협상의 결과가 중요하다고 생각합니다.

현재 네이버는 국내 미디어 회사에게 저작권이 있는 콘텐츠를 이용하기 위해 각 회사들에게 어떤 보상을 제시할 예정인가요? 혹은 어떤 방향으로 합의하실까요? 꼭 미디어 회사의 합의가 필요하지 않다고 판단하신다면 AI 개발에 필요한 데이터는 어떻게 수급할 계획일까요?

안녕하세요!

https://youtu.be/RR2WIs_KaZU?si=R9_gSKmFxIxSRMnm

챗gpt api랑 한컴오피스를 연동해서

주제만 쓰면 알아서 보고서 초안을 만들어주는 프로그램을 만들어봤습니다.

클로바x로도 만들어보고 싶어서

클로바x가 말한 정보중에서 필요한 정보만 뽑을 수 있도록 태깅작업을 지시했는데...

너는 공무원처럼 글을 써야해, 금연사업 기대효과 4개를 각각 한줄이내로 제발 앞에 "*"를 붙여서 제시해줘, 제목은 없애주고

클로바x 가 앞에 "*"를 붙이는 확률이 상당히 저조합니다...

태깅작업 성공률을 100%에 가깝게 만들려면 어떻게 질문하는 방식이 좋을까요?